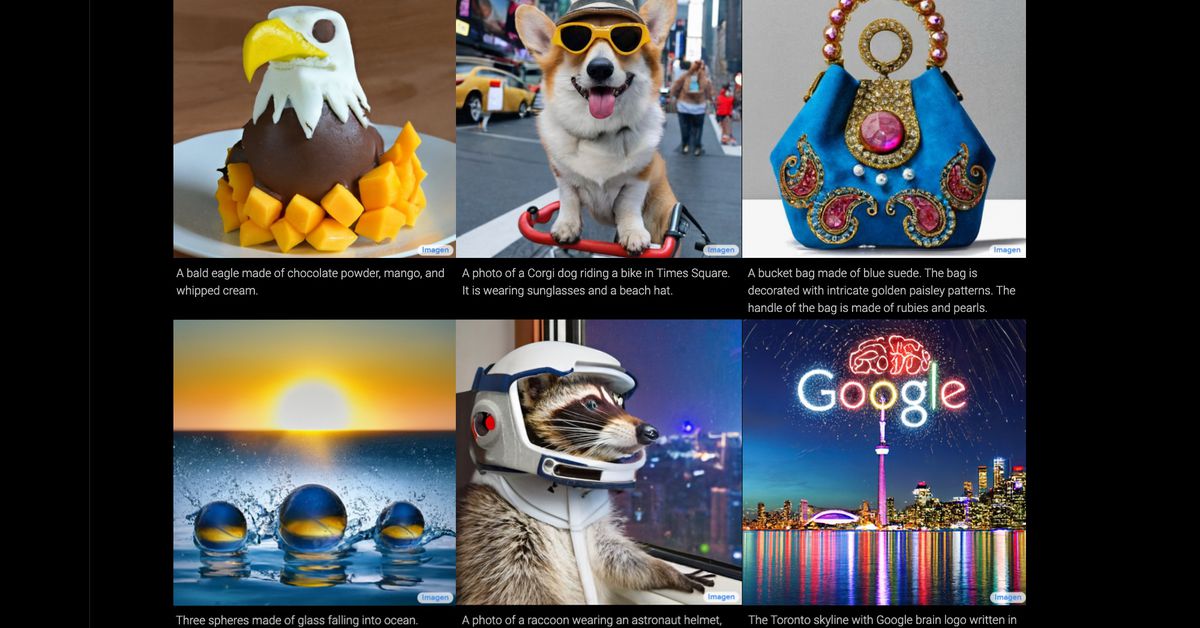

Todas estas imágenes fueron generadas por la última IA de texto a imagen de Google.

Hay una nueva tendencia en IA: generadores de texto a imagen. Dale a estos programas el texto que quieras y generarán imágenes notablemente precisas que coincidan con esa descripción. Pueden coincidir con una variedad de estilos, desde pinturas al óleo hasta renderizados CGI e incluso fotografías y, aunque suene a cliché, en muchos sentidos, el único límite es su imaginación.

Hasta la fecha, el líder en el campo es DALL-E, un programa creado por el laboratorio de IA comercial OpenAI (y actualizado hace poco de vuelta en abril). Ayer, sin embargo, Google anunció su propia versión del géneroImagen, y acaba de destronar a DALL-E en la calidad de su producción.

La mejor manera de comprender la increíble capacidad de estos patrones es simplemente mirar algunas de las imágenes que pueden generar. Hay algunos generados por Imagen arriba, y aún más abajo (puede ver más ejemplos en la página de destino dedicada de Google).

En cada caso, el texto en la parte inferior de la imagen fue el indicador introducido en el programa, y la imagen de arriba, la salida. Solo para enfatizar: eso es todo lo que se necesita. Escribes lo que quieres ver y el programa lo genera. Bastante fantástico, ¿verdad?

Pero si bien estas imágenes son innegablemente impresionantes en su consistencia y precisión, también deben tomarse con un grano de sal. Cuando equipos de investigación como Google Brain lanzan un nuevo modelo de IA, tienden a seleccionar los mejores resultados. Entonces, si bien todas estas imágenes se ven perfectamente pulidas, es posible que no representen la salida promedio del sistema de imágenes.

A menudo, las imágenes generadas por los modelos de texto a imagen aparecen sin terminar, con manchas o borrosas, problemas que hemos encontrado con las imágenes generadas por el programa DALL-E de OpenAI. (Para más información sobre los puntos débiles de los sistemas de texto e imagen, echa un vistazo a este interesante hilo de Twitter que se sumerge en los problemas con DALL-E. Esto destaca, entre otras cosas, la tendencia del sistema a malinterpretar las indicaciones y luchar con el texto y las caras).

Google, sin embargo, afirma que Imagen produce consistentemente mejores imágenes que DALL-E 2, según un nuevo punto de referencia que creó para este proyecto llamado DrawBench.

DrawBench no es una métrica particularmente compleja: es esencialmente una lista de alrededor de 200 mensajes de texto que el equipo de Google impulsó Imagen y otros generadores de texto a imagen, con la salida de cada programa luego juzgada por revisores humanos. Como muestran los gráficos a continuación, Google descubrió que los humanos generalmente preferían la producción de Imagen sobre sus rivales.

:no_upscale()/cdn.vox-cdn.com/uploads/chorus_asset/file/23584875/Screenshot_2022_05_24_at_11.00.33.png)

Sin embargo, será difícil juzgar por nosotros mismos, porque Google no pone el modelo de Imagen a disposición del público. También hay una buena razón para esto. Si bien los modelos de texto a imagen ciertamente tienen un potencial creativo fantástico, también tienen una gama de aplicaciones inquietante. Imagine un sistema que genere casi cualquier imagen que desee para usarla en noticias falsas, bromas o acoso, por ejemplo. Como señala Google, estos sistemas también codifican el sesgo social, y su salida suele ser racista, sexista o tóxica de alguna otra manera inventiva.

Esto se debe en gran parte a la forma en que se programan estos sistemas. Esencialmente, están capacitados en grandes cantidades de datos (en este caso: muchos pares de imágenes y subtítulos) que estudian en busca de patrones y aprenden a replicar. Pero estos modelos necesitan una gran cantidad de datos, y la mayoría de los investigadores, incluso aquellos que trabajan para gigantes tecnológicos bien financiados como Google, han decidido que es demasiado oneroso filtrar esta información de manera integral. Por lo tanto, extraen cantidades masivas de datos de la web y, como resultado, sus modelos ingieren (y aprenden a replicar) toda la odiosa bilis que esperaría encontrar en línea.

Como los investigadores de Google resumen este problema en su papel: «[T]Los requisitos de datos a gran escala de los modelos de texto a imagen […] han llevado a los investigadores a depender en gran medida de grandes conjuntos de datos, en su mayoría no seleccionados, recuperados de la web […] Las auditorías de los conjuntos de datos revelaron que estos conjuntos de datos tienden a reflejar estereotipos sociales, puntos de vista opresivos y asociaciones despectivas o dañinas con grupos de identidad marginados.

En otras palabras, el conocido adagio de los científicos informáticos aún se aplica en el acelerado mundo de la IA: basura adentro, basura afuera.

Google no entra en demasiados detalles sobre el contenido perturbador generado por Imagen, pero señala que el modelo «codifica varios sesgos y estereotipos sociales, incluido un sesgo general hacia la generación de imágenes de personas con tonos de piel más claros y una tendencia a imágenes que representan diferentes profesiones para alinearse con los estereotipos de género occidentales.

Esto es algo que los investigadores también encontrado al evaluar DALL-E. Pídale a DALL-E que genere imágenes de una «azafata», por ejemplo, y casi todos los sujetos serán mujeres. Pide fotos de un «CEO» y, sorpresa, sorpresa, obtienes un montón de hombres blancos.

Por esta razón, OpenAI también decidió no lanzar DALL-E públicamente, pero la compañía brinda acceso a algunos probadores beta. También filtra ciertas entradas de texto para evitar que la plantilla se utilice para generar imágenes racistas, violentas o pornográficas. Estas medidas limitan hasta cierto punto las aplicaciones potencialmente dañinas de esta tecnología, pero la historia de la IA nos dice que tales patrones de conversión de texto a imagen seguramente se harán públicos en algún momento en el futuro, con todas las implicaciones preocupantes que conlleva un acceso más amplio. . .

La propia conclusión de Google es que Imagen «no es adecuada para uso público en este momento», y la compañía dice que planea desarrollar una nueva forma de comparar «sesgos sociales y culturales en el trabajo futuro» y probar iteraciones futuras. Por ahora, sin embargo, tendremos que conformarnos con la alegre selección de imágenes de la compañía: la realeza del mapache y los cactus con gafas de sol. Sin embargo, eso es solo la punta del iceberg. El iceberg hace consecuencias no deseadas de la investigación tecnológica, si Imagen quiere embarcarse en la generación ese.

«Jugador orgulloso. Gurú del café. Alcoholico galardonado. Entusiasta de la cerveza. Estudiante. Aficionado a los zombis. Lector. Especialista en música. Aficionado a la comida».